|

Actualité de l'émulation [contenu fourni par Emu-France]

|

||

|

|||

Par Laurent (21 mai 2001)

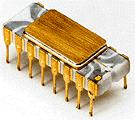

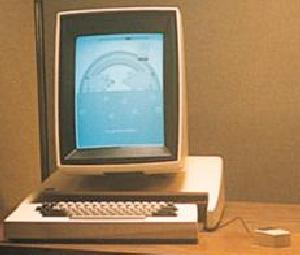

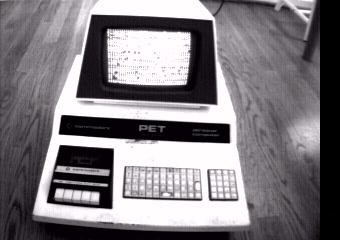

Histoire : Tous les chemins mènent au PCPC : Personal Computer. Difficile d'imaginer un nom plus rassembleur, n'évoquant tel quel aucune marque, aucune compagnie, aucun nom en particulier. Les ordinateurs compatibles avec le standard PC sont aujourd'hui les plus répandus sur la planète, et de façon durable, comme s'ils étaient les dépositaires du résultat de 5 millénaires de recherches en matière d'ordinateurs. Si l'on devait résumer en un mot la façon dont les choses en sont arrivées là, ce serait : convergence. Convergence de pensées, de travaux, de développements divers imputables à toutes sortes de gens, venus de tous les pays et travaillant pour toutes sortes de structures privées, publiques ou même militaires. Le PC n'est pas né pas comme ça, un beau jour, dans un garage, un laboratoire ou une salle de réunion. De ce fait, écrire l'historique du PC revient presque à écrire l'historique de l'informatique. D'un point de vue purement technique, les origines du PC remontent au moins aux années 50, même si on est encore loin à l'époque d'imaginer une utilité personnelle à un ordinateur. C'est à cette époque qu'on constate un changement important dans la recherche informatique (je me permets d'utiliser le mot informatique bien qu'il soit apparu beaucoup plus tard et n'existe qu'en français) : les ordinateurs cessent d'être de plus en plus gros à mesure que leur puissance de calcul augmente. Ce revirement est une des plus grandes révolutions qu'ait connu cette science, et remet totalement en question la façon dont elle va évoluer au cours des décennies suivantes.  Ceux d'entre vous qui ont lu Asimov se souviennent de ses nouvelles de science-fiction écrites dans les années 40 qui décrivent, plusieurs millénaires dans le futur, des ordinateurs grands comme des usines, puis comme des villes. Tous les ordinateurs crées par l'Homme finiraient même par fusionner en un seul, de la taille d'une planète, voire même si gros que l'univers ne serait pas assez étendu pour le contenir. Cette machine, selon les visions d'Asimov, serait capable de concevoir et fabriquer elle-même son successeur. Sa pensée et ses connaissances technologiques seraient supérieures à celles de l'Homme, et elle expédierait son successeur, un millier de fois plus vaste qu'elle, dans l'hyperespace pour résoudre le problème de l'encombrement ! Même si Asimov était un écrivain de génie qui appuyait toujours ses visions sur de solides connaissances scientifiques, ces prévisions ne se sont pas réalisées, et elles n'en prennent pas le chemin, excepté peut-être la notion théorique de fusion de tous les ordinateurs en un seul. Le standard PC va peut-être atteindre le statut d'ordinateur universel, non pas en écrasant tout par sa taille et sa puissance, mais au contraire en devenant plus proche de l'Homme. Le transistor Voici peut-être ce qu'Asimov n'avait pas anticipé : De nouveaux dieux Dès leurs débuts, les ordinateurs fascinent le public par leurs capacités de calcul. Dans toutes les universités, les bases militaires et les diverses agences gouvernementales, des laboratoires et des départements utilisant des ordinateurs sont constitués. Le géant américain IBM va alors jouer un rôle prépondérant et devenir le numéro 1 mondial de l'ordinateur.  En 1952, l'IBM 701 apparaît, capables d'exécuter 17.000 instructions à la seconde. Il s'agit d'un ordinateur constitué de plusieurs unités pouvant être facilement livrées et montées sur leur lieu d'utilisation, ce qui est une grande innovation, et l'un des premiers effets de la miniaturisation. En 1953, IBM, toujours, introduit l'IBM 650, le premier ordinateur qui va faire l'objet d'une production massive.  En 1959, suite à la généralisation de l'usage du transistor apparaît l'IBM 7090, premier ordinateur entièrement basé sur ce nouveau composant électronique. Puis en 1964, IBM va dépenser un milliard de dollars de recherche qui aboutiront à la ligne System/360, les premiers ordinateurs IBM à être compatibles entre eux (voir article sur les origines de l'émulation). Pour la première fois, l'idée d'un standard est donc évoquée.   En 1960, l'ordinateur est à son zénith. Toutes les sociétés qui travaillent à son développement engagent des armées de techniciens et d'ingénieurs pour travailler sur de nouveaux systèmes d'exploitation, de nouveaux matériels et de nouveaux logiciels. La capacité des nouvelles machines (travaillant le plus souvent avec des cartes perforées) qui apparaissent dépasse ce que l'on aurait même pu imaginer dix ans plus tôt. Mais avec l'augmentation exponentielle du nombre de données que les nouveaux ordinateurs sont amenés à gérer, le risque d'erreur augmente et même si le mot "bug" est utilisé depuis longtemps déjà, il n'a jamais aussi souvent été entendu prononcer, bien que les cafards en question aient entre temps perdu leur enveloppe charnelle et soient entrés dans la "matrice". On a là un autre aléa de l'histoire de l'informatique que les visionnaires des années 40 n'avaient pas imaginé : la faillibilité matérielle de l'ordinateur, qui diminue à mesure que ses performances augmentent. Néanmoins, même si l'on commence à considérer l'ordinateur d'un œil plus réaliste, ses prouesses n'en finissent pas d'impressionner. Ainsi, aux USA, en 1961, un ordinateur calcule le nombre Pi jusqu'à la 100.000e décimale. Un autre joue aux échecs et se voit bombardé membre honoraire de la United States Chess Federation. Plus sérieusement, c'est à cette époque que les banques américaines commencent à imprimer les chèques avec de l'encre magnétique afin de les faire traiter par des ordinateurs. Une autre étapeJusqu'au début des années 70, l'image typique de l'ordinateur n'est plus celle d'une gigantesque machinerie, mais on ne saurait encore l'imaginer autrement qu'enfermé dans une salle climatisée, pendant que dans la pièce d'à côté un opérateur utilise une petite interface de commande. En 1968, le HAL de 2001 l'odyssée de l'espace, représentant pourtant l'ordinateur du futur (avec ses forces et faiblesses), n'échappe pas à ce cliché.  En 1971, la compagnie Intel (fondée par Robert Noyce, co-inventeur du circuit intégré) va introduire un nouveau concept : la miniaturisation des transistors, et leur concentration en un seul composant, qui deviendrait le cerveau de l'ordinateur par lequel tous les calculs transiteraient. On assiste alors à la naissance du microprocesseur, inventé par Marcian Hoff, Stanley Mazor et Federico Faggin. Le premier du genre sera l'Intel 4004 (4-bits, 108 Khz, contenant environ 2000 transistors), qui va permettre dans un premier temps l'apparition des calculatrices de poche programmables, inventées chez Hewlett-Packard.     Jusque là les ordinateurs ont surtout été utilisés pour gérer des données numériques et faire des calculs. Le texte est surtout l'affaire des téléscripteurs et des photocopieurs, dont Xerox est le leader.  En 1972, Intel lance le 8008 (200 Khz), capable de gérer des données binaires sur 8-bits, ce qui est suffisant pour coder toutes les lettres de l'alphabet. C'est cette même année que Xerox commence à travailler dans son centre de recherche de Palo Alto sur un projet d'ordinateur équipé d'un écran, qui pourrait, grâce à son encombrement (et son prix) réduit, être utilisé dans un bureau pour des tâches conciliant calcul et traitement de texte. Grâce aux stations de travail Xerox Alto, chaque personne, dans une entreprise, pourrait ainsi avoir son propre ordinateur, qui deviendrait une véritable "machine à tout faire". De même, en 1972, Digital Equipment Corporation (DEC), fabricant de mini-ordinateurs dirigé par Kenneth Olsen, met un groupe d'ingénieurs au travail sur un projet similaire, le DEC Datacenter.   Ces deux projets, qui n'ont pas eu les répercussions commerciales désirées, seront par la suite abandonnés. Peut-être sont-ils arrivés trop tôt, mais on peut penser que s'ils avaient été menés à bien, l'un d'eux tiendrait peut-être la place qu'occupe le PC aujourd'hui. Le Xerox Alto est même encore plus révolutionnaire que ce que ses géniteurs imaginent, puisqu'il introduit en 1973 (10 ans avant le Mac) l'usage de la souris et de l'interface graphique utilisateur (les commandes principales se font en cliquant sur des commandes à l'écran, et non plus en les tapant au clavier). C'est bien à cette époque que la notion d'"ordinateur personnel" est née. Le micro-processeur était l'élément qui manquait pour que le processus de miniaturisation appliqué aux ordinateurs arrive à maturité et que les mini-ordinateurs, devenant des micro-ordinateurs, puisse toucher un plus large public. Néanmoins, le reste de l'évolution qui a abouti à la naissance du PC chez IBM n'est pas le fait des grandes compagnies. On le doit plutôt aux diverses réussites de jeunes inventeurs de génie, un peu rebelles, dont les idées sont si larges et audacieuses qu'elles ne trouvent pas leur place dans les grandes structures un peu trop hiérarchisées que sont IBM, Xerox ou DEC. Genese du PC En 1975, le Rubik's Cube, inventé par le Hongrois Erno Rubik, vient de manière amusante rappeler à l'Homme la faiblesse des ses capacités intellectuelles. Dans le monde entier des millions d'exemplaires s'en vendent alors que moins d'un joueur sur cent est capable de venir à bout du casse-tête qu'il représente. Une lueur d'espoir apparaît alors, venue de chez MITS (Micro Instrumentation and Telemetry Systems) : l'Altair 8800, un micro-ordinateur basé sur le CPU Intel 8008 et vendu en kit pour un usage de loisir auprès du grand public. Bien que très "spartiate" il obtient un franc succès, probablement grâce à la valorisation qu'il représente pour l'utilisateur un rien bricoleur qui se retrouve capable de monter et d'utiliser un ordinateur, à une époque où l'usage ce genre d'appareil est encore réservé à une certaine élite.  L'Altair 8800 prouve que l'ordinateur personnel vendu au grand public peut marcher auprès des bidouilleurs qui triturent leur fer à souder dans leur garage. Cette machine ne va pas faire long feu sur le marché, mais on lui doit probablement la naissance d'une des grandes compagnies qui ont joué un rôle prépondérant dans l'histoire du PC : en 1974, Bill Gates et Paul Allen, deux jeunes surdoués qui ont du mal à concilier leurs études supérieures et leur passion pour les ordinateurs, développent un langage BASIC pour l'Altair dont la vente de la licence à MITS va leur permettre de fonder Microsoft.  En 1976, un autre micro-ordinateur est proposé aux amateurs : l'Apple I. Encore une machine qui s'est créée dans des conditions d'amateurisme total, bien loin des laboratoires aseptisés d'IBM ou Xerox. Stephen Wozniak et Steve Jobs, après ce coup de maître, vont devoir vendre une partie de leurs possessions personnelles pour monter Apple Computers. En 1977, il lanceront l'Apple II, un ordinateur pré-assemblé muni d'un moniteur couleur, capable de produire du son et des graphismes en haute résolution.   Pendant ce temps, les grandes compagnies qui ont fait les grandes heures des ordinateurs dans les deux décennies précédentes observent le travail des "petits nouveaux" d'un œil amusé, mais sont encore loin de les prendre au sérieux. Comment une entreprise portant le nom d'un fruit peut-elle faire trembler de tels géants, dont les fondations remontent pour certains au début du siècle ? Pourtant, ils ne sont pas au bout de leurs surprises.  En 1977, apparaît le Tandy Radio Shack TRS-80 (souvent appelé aux US le "Trash 80"), basé sur le CPU Zilog Z80 qui date déjà de 1975. La même année, Commodore introduit son premier micro-ordinateur, le PET (Personal Electronic Transactor, et le mot pet signifie "animal de compagnie").   Ces machines vont alors dominer le marché de la micro-informatique grand public, s'adressant avant tout à une clientèle de fous d'électroniques en quête d'amusement, mais faisant la nique aux mastodontes de l'industrie qui se retrouvent cantonnés au milieu professionnel, et écartés d'une évolution qu'ils avaient pourtant initiée.  A partir de 1980, la plupart des micro-ordinateurs dit "personnels" utilisent le système d'exploitation de Digital Research, le CP/M (Central Program for Microprocessors) développé par Gary Kildall, dont le principal handicap est de ne pas rendre toutes les machines qui l'utilisent compatibles entre elles si elles utilisent des système d'écriture de fichier différents. A la même époque apparaissent le lecteur de disquettes (sur l'Apple II) et le premier tableur, VisiCalc, crée par Dan Bricklin et Bob Frankston, deux inventions qui vont largement contribuer à rendre l'usage d'un micro-ordinateur indispensable dans le milieu professionnel.  Le fossé entre les "monstres" encore fabriqués par les grandes compagnies et les "joujoux" fabriqués par les entreprises dites de "garage" commence alors à se resserrer. Les micro-processeurs et autres gadgets électroniques sont déjà bien introduits dans les habitudes et les foyers. En dehors des micro-ordinateurs, le magnétoscope quitte les studios de télévision et trouve sa place auprès des téléviseurs familiaux avec l'apparition du VHS, du Betamax (de Sony) et du V-2000 (de Philips), trois standards de cassettes vidéo. Le Walkman, toujours chez Sony, est aussi introduit en ce début de décennie. Les Apple, Tandy et Commodore ont vu juste : l'avenir de la micro-informatique passe par le grand public.   En Europe, Clive Sinclair parvient à convaincre une clientèle potentielle jusque là repoussée par le prix des micros en vogue, avec ses ZX-80 et ZX-81 qui utilisent le même CPU que les Commodore PET et Tandy TRS-80, mais équipés de moins de mémoire et vendus à un prix ridicule dans des boîtiers tous petits, peu coûteux, imaginés par des designers très inspirés. Commodore suit le mouvement avec le VIC-20, un autre ordinateur personnel accessible à tous par son prix et sa facilité d'utilisation.     L'ordinateur et le jeu vidéoIl aura fallu un certain temps avant que les jeux vidéo soient admis comme une utilisation acceptable d'un ordinateur. Les premières expériences de jeu vidéo remontent aux années 50, et ont presque toujours été faites sur des ordinateurs (qui commençaient à l'époque à utiliser un écran à la place des bandes perforées), à l'exception de la "télévision ludique" de Ralph Baer qui préfigure, elle, la console de jeux. Néanmoins, ce ne furent là que des expériences faites pour se divertir par des scientifiques, et l'apparition du jeu vidéo en tant que produit commercialisable a du attendre les années 70, avec les travaux parallèles de Nolan Bushnell et de Magnavox. A l'époque, les jeux vidéo ont été présentés au public comme un produit à part entière, et non pas comme un usage possible d'un ordinateur, bien que dès 1976 les consoles de jeux aient contenu une électronique voisine de celui d'un micro-ordinateur. Les grandes compagnies ayant bien autre chose à faire que divertir leurs clients, il aura fallu, une nouvelle fois, attendre l'entrée en scène des jeunes rebelles de la micro-informatique pour que jeu vidéo et ordinateur soient liés dans leur évolution. L'exemple le plus flagrant est l'Apple I. Steve Wozniak et Steve Jobs, avant de fonder Apple, ont travaillé sur un jeu vidéo, Breakout, en 1976. Jobs était alors employé chez Atari, et avait fait appel au génie de l'électronique qu'était Wozniak pour mettre au point ce jeu d'arcade qu'on lui avait demandé de programmer en un temps record. Wozniak a plus tard confirmé que les travaux réalisés sur ce jeu lui ont par la suite été très utiles lors de la mise au point de l'Apple I. Lorsque l'Apple II est sorti, plus tard, avec ses graphismes en couleurs, de nombreux jeux sont venus étoffer son catalogue de logiciels, et Apple a parfaitement su exploiter l'effet produit par ses jeux en tant que démonstration de la puissance de sa machine. Tandy, Commodore et les autres nouveaux acteurs du marché de la micro-informatique ont suivi l'exemple et ont encouragé le développement de jeux sur leurs machines. On pense notamment au VIC-20 qui est peut-être le premier micro-ordinateur à avoir détourné l'attention des amateurs de jeu vidéo des consoles. Au début des années 80, alors qu'apparaissent continuellement de nouveaux micros et de nouvelles compagnies, le jeu vidéo est encore la seule utilisation de telles machines qui puisse intéresser tout le monde. L'utilisateur moyen n'a en vérité rien à faire d'un tableur, ou même d'un traitement de texte (les imprimantes ne sont pas encore abordables pour tout le monde), à moins d'être simplement attiré par le plaisir de toucher un peu à la haute technologie. Il y a bien quelques applications pédagogiques à un ordinateur, mais elles ne justifient pas l'investissement. Le jeu vidéo est donc, et pour longtemps encore, l'argument massu pour convaincre le public et la clé de la réussite, d'autant plus qu'il ne nécessite (à l'époque !) pas de stockage de données massif et ne tire donc pas trop vers le haut le prix de vente de l'ordinateur.

Envie de réagir ? Cliquez ici pour accéder au forum |